Porno non consensuelle générée par IA : une explosion en popularité qui inquiète

GoogleAds

Des sites qui permettent de dénuder, en quelques clics et sans consentement, n’importe qui dans une photo à l’aide de l’intelligence artificielle (IA) connaissent une explosion de popularité. Des dizaines de millions de personnes visitent ces sites chaque mois, ont constaté les Décrypteurs. La situation fait bondir des experts, qui s’inquiètent de l’impact qu’elle pourrait avoir, surtout chez les jeunes.

Activez la puissance de notre modèle d’intelligence artificielle pour générer des photos nues. Dénudez n’importe quelle fille en ligne gratuitement, promet un de ces sites. La page d’accueil contient une photo de l’actrice britannique Emma Watson, graduellement dénudée par un ordinateur.

Ce site, qui existe seulement depuis juillet, a été visité 3,2 millions de fois au cours du dernier mois, selon l’outil d’analyse Similarweb. Et il est loin d’être le plus populaire de ceux que nous avons recensés.

Les cinq sites les plus visités du lot ont cumulé 18,5 millions de visites uniques et 145 millions de pages vues au cours du dernier mois. L’un d’entre eux comporte une salle de clavardage sur l’application de messagerie Telegram qui compte près de 500 000 abonnés. Tous ont été créés cet été, au plus tôt.

Depuis le lancement, l’année dernière, de générateurs d’images par IA publiquement accessibles, certains utilisateurs ont décidé de mettre au point des outils servant à créer des images explicites. Ces services requièrent généralement de télécharger un logiciel et d’apprendre à l’utiliser correctement, ce qui n’est pas à la portée de tout un chacun.

En contrepartie, aucune expertise n’est requise pour les sites que nous avons répertoriés.

Une émission spéciale sur l’intelligence artificielle sera diffusée le 7 décembre à 20 h sur les ondes d’ICI TÉLÉ et ICI RDI de même que sur nos plateformes numériques.

Nous avons testé l’un d’entre eux à l’aide d’une image que nous avions créée par IA. Celle-ci montre une jeune femme à la plage portant une robe d’été, une photo que bien des gens ne seraient pas gênés de publier sur les réseaux sociaux.

Il nous a suffi de la téléverser et l’algorithme s’est occupé du reste. Il a automatiquement détecté les vêtements et les a retirés, en les remplaçant par l’approximation extrêmement fidèle d’un corps nu. Le tout n’a pris que quelques minutes, et les résultats étaient très convaincants.

Même si les conditions d’utilisation de ces sites interdisent de créer des photos nues sans la permission du sujet, l’aspect non consensuel fait partie de l’argument de vente.

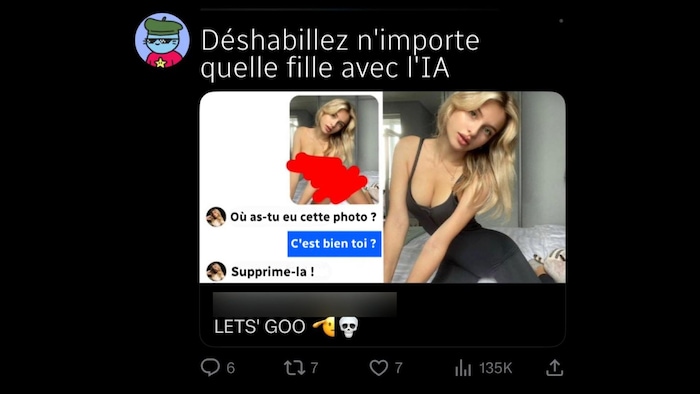

La semaine dernière, des publicités pour un de ces sites, diffusées sur X, mettaient en scène un homme qui envoyait par texto à une femme une photo nue d’elle générée par IA. Où as-tu trouvé ça? Supprime-la! répond la femme dans l’annonce.

Ouvrir en mode plein écran

Capture d’écran d’une publicité mettant de l’avant l’aspect non consensuel de ces services.

Photo : X

L’IA : un tremplin pour la pédopornographie

L’impact des sites de mise à nu automatique par IA se fait déjà sentir chez les jeunes.

Il y a quelques semaines, les autorités de la ville d’Almendralejo, en Espagne, affirmaient qu’une vingtaine de jeunes filles âgées de 12 à 14 ans (Nouvelle fenêtre) avaient reçu des images nues d’elles-mêmes générées par IA. Des camarades de classe masculins avaient pris leurs photos sur les réseaux sociaux, les avaient modifiées grâce à ces sites, puis les avaient partagées dans une salle de clavardage privée.

Ma fille m’a dit avec un profond dégoût : “Maman, regarde ce qu’ils m’ont fait”, a déclaré la mère d’une des victimes, âgée de 14 ans. Ces photomontages sont ultraréalistes, c’est profondément troublant et un réel scandale.

Depuis sa création, Internet a toujours été un terreau fertile pour les adeptes de pédopornographie, et l’accès accru à des outils sophistiqués d’IA ne fait qu’amplifier ce fléau.

L’exemple récent de Steven Larouche illustre bien cette troublante réalité.

Ce Sherbrookois âgé de 61 ans s’est bâti une collection de pornographie juvénile qui défie l’entendement. Une enquête a permis de déterminer qu’il avait en sa possession plus de 80 000 photos d’enfants entièrement créées par IA.

Imaginez ce que toute la communauté des amateurs de matériel pédopornographique peut arriver à produire, se désole René Morin, porte-parole du Centre canadien de protection de l’enfance, dont le travail se bute à la multiplication de ce type de contenus

Avec l’intelligence artificielle, on craint un afflux de matériel neuf qui aura potentiellement pour effet de surcharger tous les services de première ligne, qu’il s’agisse des tribunaux, des autorités policières ou encore d’organisations comme la nôtre qui luttent contre l’exploitation sexuelle des enfants.

Ouvrir en mode plein écran

Le porte-parole du Centre canadien de protection de l’enfance, René Morin, en entrevue avec les Décrypteurs.

Photo : Radio-Canada

Selon M. Morin, il ne faut surtout pas tomber dans le piège de croire que la pornographie juvénile générée par IA est moins problématique.

Le simple fait qu’on puisse produire de telles images sous forme de photos ou de vidéos permet à des individus avec des déviances de nourrir leurs fantasmes, signale-t-il. Ça devient inquiétant parce que plusieurs études ont démontré que consommer ce genre de matériel-là peut souvent mener à des passages à l’acte.

Il ne faut pas non plus penser que les lois existantes ne s’appliquent pas sur une image modifiée par IA, où seul le visage resterait intact alors que le corps serait artificiellement dénudé, martèle l’avocate Éloïse Gratton.

Ce n’est pas parce que la photo est modifiée que les lois ne s’appliquent plus : toutes les lois en matière de vie privée s’appliquent, les enjeux de réputation s’appliquent, et les infractions de nature criminelle s’appliquent.

Sur le plan légal, l’élément clé dans toute cette affaire est bien sûr l’absence de consentement.

Aux yeux de Me Gratton, ce qui cloche avec les sites web qui utilisent l’IA pour produire des images à caractère sexuel est l’absence de mesures efficaces de consentement et de mécanismes empêchant la publication subséquente des images générées.

Si de telles mesures étaient adoptées, elles viendraient démolir le modèle d’affaires de ces entreprises, souligne l’avocate.

René Morin et Éloïse Gratton ont été interviewés dans le cadre de l’émission Décrypteurs, diffusée ce samedi à 11 h 30 sur ICI RDI et en reprise dimanche à 13 h, en plus d’être accessible gratuitement sur ICI TOU.TV (Nouvelle fenêtre).

Source : https://ici.radio-canada.ca/nouvelle/2031358/pornographie-non-consensuelle-intelligence-artificielle

Auteur :

Date de Publication : 2023-12-01 10:00:00

Le droit d’auteur pour le contenu syndiqué appartient à la source liée.

GoogleAds